Методы измерения количества информации

Для информации существуют свои единицы измерения информации. Если рассматривать сообщения информации как последовательность знаков, то их можно представлять битами, а измерять в байтах, килобайтах, мегабайтах, гигабайтах, терабайтах и петабайтах.

Давайте разберемся с этим, ведь нам придется измерять объем памяти и быстродействие компьютера.

Единицей измерения количества информации является бит – это наименьшая (элементарная) единица.

Байт – основная единица измерения количества информации.

Байт – довольно мелкая единица измерения информации. Например, 1 символ – это 1 байт.

Производные единицы измерения количества информации

1 килобайт (Кб)=1024 байта =2 10 байтов

1 мегабайт (Мб)=1024 килобайта =2 10 килобайтов=2 20 байтов

1 гигабайт (Гб)=1024 мегабайта =2 10 мегабайтов=2 30 байтов

1 терабайт (Гб)=1024 гигабайта =2 10 гигабайтов=2 40 байтов

Запомните, приставка КИЛО в информатике – это не 1000, а 1024, то есть 2 10 .

Методы измерения количества информации

Итак, количество информации в 1 бит вдвое уменьшает неопределенность знаний. Связь же между количеством возможных событий N и количеством информации I определяется формулой Хартли:

Алфавитный подход к измерению количества информации

При этом подходе отвлекаются от содержания (смысла) информации и рассматривают ее как последовательность знаков определенной знаковой системы. Набор символов языка, т.е. его алфавит можно рассматривать как различные возможные события. Тогда, если считать, что появление символов в сообщении равновероятно, по формуле Хартли можно рассчитать, какое количество информации несет в себе каждый символ:

Вероятностный подход к измерению количества информации

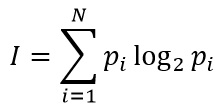

Этот подход применяют, когда возможные события имеют различные вероятности реализации. В этом случае количество информации определяют по формуле Шеннона:

I – количество информации,

N – количество возможных событий,

Pi – вероятность i-го события.

Задача 1.

Шар находится в одной из четырех коробок. Сколько бит информации несет сообщение о том, в какой именно коробке находится шар.

Имеется 4 равновероятных события (N=4).

По формуле Хартли имеем: 4=2 i . Так как 2 2 =2 i , то i=2. Значит, это сообщение содержит 2 бита информации.

Задача 2.

Чему равен информационный объем одного символа русского языка?

В русском языке 32 буквы (буква ё обычно не используется), то есть количество событий будет равно 32. Найдем информационный объем одного символа. I=log2 N=log2 32=5 битов (2 5 =32).

Примечание. Если невозможно найти целую степень числа, то округление производится в большую сторону.

Задача 3.

Чему равен информационный объем одного символа английского языка?

Задача 4.

Световое табло состоит из лампочек, каждая из которых может находиться в одном из двух состояний (“включено” или “выключено”). Какое наименьшее количество лампочек должно находиться на табло, чтобы с его помощью можно было передать 50 различных сигналов?

С помощью N лампочек, каждая из которых может находиться в одном из двух состояний, можно закодировать 2 N сигналов.

2 5 6 , поэтому пяти лампочек недостаточно, а шести хватит. Значит, нужно 6 лампочек.

Задача 5.

Метеостанция ведет наблюдения за влажностью воздуха. Результатом одного измерения является целое число от 0 до 100, которое записывается при помощи минимально возможного количества битов. Станция сделала 80 измерений. Определите информационный объем результатов наблюдений.

В данном случае алфавитом является множество чисел от 0 до 100, всего 101 значение. Поэтому информационный объем результатов одного измерения I=log2101. Но это значение не будет целочисленным, поэтому заменим число 101 ближайшей к нему степенью двойки, большей, чем 101. это число 128=2 7 . Принимаем для одного измерения I=log2128=7 битов. Для 80 измерений общий информационный объем равен 80*7 = 560 битов = 70 байтов.

Задача 6.

Определите количество информации, которое будет получено после подбрасывания несимметричной 4-гранной пирамидки, если делают один бросок.

Пусть при бросании 4-гранной несимметричной пирамидки вероятности отдельных событий будут равны: p1=1/2, p2=1/4, p3=1/8, p4=1/8.

Тогда количество информации, которое будет получено после реализации одного из них, можно вычислить по формуле Шеннона:

I = -[1/2 * log2(1/2) + 1/4 * log2(1/4) + 1/8 * log(1/8) + 1/8 * log(1/8)] = 14/8 битов = 1,75 бита.

Задача 7.

В книге 100 страниц; на каждой странице – 20 строк, в каждой строке – 50 символов. Определите объем информации, содержащийся в книге.

Задача 8.

Оцените информационный объем следующего предложения:

Тяжело в ученье – легко в бою!

Так как каждый символ кодируется одним байтом, нам только нужно подсчитать количество символов, но при этом не забываем считать знаки препинания и пробелы. Всего получаем 30 символов. А это означает, что информационный объем данного сообщения составляет 30 байтов или 30 * 8 = 240 битов.

Измерение информации

Средняя оценка: 4.4

Всего получено оценок: 397.

Средняя оценка: 4.4

Всего получено оценок: 397.

Как и любую другую физическую величину, информацию можно измерить. Существуют разные подходы к измерению информации. Один из таких подходов рассматривается в курсе информатики за 7 класс.

Что такое измерение информации

При измерении информации следует учитывать как объем передаваемого сообщения, так и его смысловую нагрузку. В связи с этим в информатике существуют разные подходы к измерению информации.

Алфавитный подход к измерению информации

Способы оценки величины информации могут учитывать или не учитывать смысла информационного сообщения.

Один из способов нахождения количества информации основан на определении веса каждого символа в тексте сообщения. При таком подходе объем сообщения зависит от количества знаков в тексте, чем больше тест, тем больше весит информационное сообщение. При этом абсолютно не важно, что написано, какой смысл несет сообщение. Так как определение объема информации привязано к текстовым единицам: буквам, цифрам, знакам препинания, то такой подход к измерению информации получил название алфавитного.

Вес отдельного знака зависит от их количества в алфавите. Число символов алфавита называют мощностью (N). Например, мощность алфавита английского языка по числу символов равно 26, русского языка 33. Но на самом деле, при написании текста используются и прописные и строчные буквы, а также знаки препинания, пробелы и специальные невидимые символы, обозначающие конец абзаца и перевод к новой строке. Поэтому имеют дело с мощностью 128 или в расширенной версии 256 символов.

Бит, байт и другие единицы измерения

Для двоичного алфавита, состоящего из двух символов – нуля и единицы, мощность алфавита будет составлять 2. Вес символа бинарного алфавита выбран в качестве минимальной единицы информации и называется «бит». Происхождение термина «бит» исходит от англоязычного слова «binary», что означает двоичный.

Восемь бит образуют байт.

Название «байт» было придумано в 1956 году В. Бухгольцем при проектировании первого суперкомпьютера. Слово «byte» было получено путем замены второй буквы в созвучном слове «bite», чтобы избежать путаницы с уже имеющимся термином «bit».

На практике величина объема информации выражает в более крупных единицах: килобайтах, терабайтах, мегабайтах.

Следует запомнить, что килобайт равен 1024 байта, а не 1000. Как, например, 1 километр равен 1000 метрам. Эта разница получается за счет того, 1 байт равен 8 битам, а не 10.

Для того, чтобы легче запомнить единицы измерения, следует воспользоваться таблицей степени двойки.

Таблица степеней двойки

Показатель степени

Значение

То есть, 2 3 = 8 – это 1 байт, состоящий из 8 бит, 2 10 = 1024 это 1 килобайт, 2 20 = 1048576 представляет собой 1 мегабайт, 2 30 = 1 гигабайт, 2 40 = 1 терабайт.

Определение количества информации

Вес символа (i) и мощность алфавита (N) связаны между собой соотношением: 2 i = N.

Так, алфавит мощностью в 256 символов имеет вес каждого символа в 8 бит, то есть один байт. Это означает, что на каждую букву приходится по байту. В таком случае, нетрудно определить, сколько весит весь кодируемый текст сообщения. Для этого достаточно вес символа алфавита умножить на количество символов в тексте. При подсчете количества символов в сообщении следует не забывать, что знаки препинания, а также пробелы – это тоже символы и они весят столько же, сколько и буквы.

Например, при условии, что каждая буква кодируется одним байтом, для текста, «Ура! Наступили каникулы.» информационный объем определяется умножением 8 битов на 24 символа (без учета кавычек). Произведение 8 * 24 = 192 бита – столько весит кодируемая фраза. В переводе на байты: 192 бита разделить на 8 получим 24 байта.

Эта схема работает и в обратной задаче. Пусть информационное сообщение составляет 2 килобайта и состоит из 512 символов. Необходимо определить мощность алфавита, используемого для кодирования сообщения.

Решение: Сначала целесообразно 2 килобайта перевести в биты: 2 * 1024 = 2048 (бит). Затем объем информационного сообщения делят на количество символов: 2048 / 512 = 4 (бит), получают вес одного символа. Для определения мощности алфавита 2 возводят в степень 4 и получают 16 – это мощность алфавита, то есть количество символов, используемых для кодирования текста.

Что мы узнали?

Одним из способов определения величины информационного сообщения является алфавитный подход, в котором любой знак в тексте имеет некоторый вес, обусловленный мощностью алфавита. Минимальной единицей измерения информации является бит. Информацию можно также измерять в байтах, килобайтах, мегабайтах.

Информатика. 7 класс

Конспект урока

Информатика

Единицы измерения информации

Перечень вопросов, рассматриваемых в теме:

- Алфавитный подход к измерению информации.

- Наименьшая единица измерения информации.

- Информационный вес одного символа алфавита и информационный объём всего сообщения.

- Единицы измерения информации.

- Задачи по теме урока.

Каждый символ информационного сообщения несёт фиксированное количество информации.

Единицей измерения количества информации является бит – это наименьшаяединица.

1 Кб (килобайт) = 1024 байта= 2 10 байтов

1 Мб (мегабайт) = 1024 Кб = 2 10 Кб

1 Гб (гигабайт) = 1024 Мб = 2 10 Мб

1 Тб (терабайт) =1024 Гб = 2 10 Гб

Формулы, которые используются при решении типовых задач:

Информационный вес символа алфавита и мощность алфавита связаны между собой соотношением: N = 2 i .

Информационный объём сообщения определяется по формуле:

I – объём информации в сообщении;

К – количество символов в сообщении;

i – информационный вес одного символа.

Основная литература:

- Босова Л. Л. Информатика: 7 класс. // Босова Л. Л., Босова А. Ю. – М.: БИНОМ, 2017. – 226 с.

Дополнительная литература:

- Босова Л. Л. Информатика: 7–9 классы. Методическое пособие. // Босова Л. Л., Босова А. Ю., Анатольев А. В., Аквилянов Н.А. – М.: БИНОМ, 2019. – 512 с.

- Босова Л. Л. Информатика. Рабочая тетрадь для 7 класса. Ч 1. // Босова Л. Л., Босова А. Ю. – М.: БИНОМ, 2019. – 160 с.

- Босова Л. Л. Информатика. Рабочая тетрадь для 7 класса. Ч 2. // Босова Л. Л., Босова А. Ю. – М.: БИНОМ, 2019. – 160 с.

- Гейн А. Г. Информатика: 7 класс. // Гейн А. Г., Юнерман Н. А., Гейн А.А. – М.: Просвещение, 2012. – 198 с.

Теоретический материал для самостоятельного изучения.

Любое сообщение несёт некоторое количество информации. Как же его измерить?

Одним из способов измерения информации является алфавитный подход, который говорит о том, что каждый символ любого сообщения имеет определённый информационный вес, то есть несёт фиксированное количество информации.

Сегодня на уроке мы узнаем, чему равен информационный вес одного символа и научимся определять информационный объём сообщения.

Что же такое символ в компьютере? Символом в компьютере является любая буква, цифра, знак препинания, специальный символ и прочее, что можно ввести с помощью клавиатуры. Но компьютер не понимает человеческий язык, он каждый символ кодирует. Вся информация в компьютере представляется в виде нулей и единичек. И вот эти нули и единички называются битом.

Информационный вес символа двоичного алфавита принят за минимальную единицу измерения информации и называется один бит.

Алфавит любого понятного нам языка можно заменить двоичным алфавитом. При этом мощность исходного алфавита связана с разрядностью двоичного кода соотношением: N = 2 i .

Эту формулу можно применять для вычисления информационного веса одного символа любого произвольного алфавита.

Рассмотрим пример:

Алфавит древнего племени содержит 16 символов. Определите информационный вес одного символа этого алфавита.

Составим краткую запись условия задачи и решим её:

16 = 2 i , 2 4 = 2 i , т. е. i = 4

Ответ: i = 4 бита.

Информационный вес одного символа этого алфавита составляет 4 бита.

Сообщение состоит из множества символов, каждый из которых имеет свой информационный вес. Поэтому, чтобы вычислить объём информации всего сообщения, нужно количество символов, имеющихся в сообщении, умножить на информационный вес одного символа.

Математически это произведение записывается так: I = К · i.

Например: сообщение, записанное буквами 32-символьного алфавита, содержит 180 символов. Какое количество информации оно несёт?

32 = 2 i , 2 5 = 2 i , т.о. i = 5,

I = 180 · 5 = 900 бит.

Ответ: I = 900 бит.

Итак, информационный вес всего сообщения равен 900 бит.

В алфавитном подходе не учитывается содержание самого сообщения. Чтобы вычислить объём содержания в сообщении, нужно знать количество символов в сообщении, информационный вес одного символа и мощность алфавита. То есть, чтобы определить информационный вес сообщения: «сегодня хорошая погода», нужно сосчитать количество символов в этом сообщении и умножить это число на восемь.

I = 23 · 8 = 184 бита.

Значит, сообщение весит 184 бита.

Как и в математике, в информатике тоже есть кратные единицы измерения информации. Так, величина равная восьми битам, называется байтом.

Бит и байт – это мелкие единицы измерения. На практике для измерения информационных объёмов используют более крупные единицы: килобайт, мегабайт, гигабайт и другие.

1 Кб (килобайт) = 1024 байта= 2 10 байтов

1 Мб (мегабайт) = 1024 Кб = 2 10 Кб

1 Гб (гигабайт) = 1024 Мб = 2 10 Мб

1 Тб (терабайт) =1024 Гб = 2 10 Гб

Итак, сегодня мы узнали, что собой представляет алфавитный подход к измерению информации, выяснили, в каких единицах измеряется информация и научились определять информационный вес одного символа и информационный объём сообщения.

Материал для углубленного изучения темы.

Как текстовая информация выглядит в памяти компьютера.

Набирая текст на клавиатуре, мы видим привычные для нас знаки (цифры, буквы и т.д.). В оперативную память компьютера они попадают только в виде двоичного кода. Двоичный код каждого символа, выглядит восьмизначным числом, например 00111111. Теперь возникает вопрос, какой именно восьмизначный двоичный код поставить в соответствие каждому символу?

Все символы компьютерного алфавита пронумерованы от 0 до 255. Каждому номеру соответствует восьмиразрядный двоичный код от 00000000 до 11111111. Этот код ‑ просто порядковый номер символа в двоичной системе счисления.

Таблица, в которой всем символам компьютерного алфавита поставлены в соответствие порядковые номера, называется таблицей кодировки.Таблица для кодировки – это «шпаргалка», в которой указаны символы алфавита в соответствии порядковому номеру. Для разных типов компьютеров используются различные таблицы кодировки.

Таблица ASCII (или Аски), стала международным стандартом для персональных компьютеров. Она имеет две части.

В этой таблице латинские буквы (прописные и строчные) располагаются в алфавитном порядке. Расположение цифр также упорядочено по возрастанию значений. Это правило соблюдается и в других таблицах кодировки и называется принципом последовательного кодирования алфавитов. Благодаря этому понятие «алфавитный порядок» сохраняется и в машинном представлении символьной информации. Для русского алфавита принцип последовательного кодирования соблюдается не всегда.

Запишем, например, внутреннее представление слова «file». В памяти компьютера оно займет 4 байта со следующим содержанием:

01100110 01101001 01101100 01100101.

А теперь попробуем решить обратную задачу. Какое слово записано следующим двоичным кодом:

01100100 01101001 01110011 01101011?

В таблице 2 приведен один из вариантов второй половины кодовой таблицы АSСII, который называется альтернативной кодировкой. Видно, что в ней для букв русского алфавита соблюдается принцип последовательного кодирования.

Вывод: все тексты вводятся в память компьютера с помощью клавиатуры. На клавишах написаны привычные для нас буквы, цифры, знаки препинания и другие символы. В оперативную память они попадают в форме двоичного кода.

Из памяти же компьютера текст может быть выведен на экран или на печать в символьной форме.

Сейчас используют целых пять систем кодировок русского алфавита (КОИ8-Р, Windows, MS-DOS, Macintosh и ISO). Из-за количества систем кодировок и отсутствия одного стандарта, очень часто возникают недоразумения с переносом русского текста в компьютерный его вид. Поэтому, всегда нужно уточнять, какая система кодирования установлена на компьютере.

Разбор решения заданий тренировочного модуля

№1. Определите информационный вес символа в сообщении, если мощность алфавита равна 32?

Информационный вес символа алфавита и мощность алфавита связаны между собой соотношением: N = 2 i .

32 = 2 i , 32 – это 2 5 , следовательно, i =5 битов.

Ответ: 5 битов.

№2. Выразите в килобайтах 2 16 байтов.

2 16 можно представить как 2 6 · 2 10 .

2 6 = 64, а 2 10 байт – это 1 Кб. Значит, 64 · 1 = 64 Кб.

Ответ: 64 Кб.

№3. Тип задания: выделение цветом

8 х = 32 Кб, найдите х.

8 можно представить как 2 3 . А 32 Кб переведём в биты.

Методы измерения количества информации

Вопросы к зачету

Информация и ее кодирование.

Термин “информация” происходит от латинского слова informatio, означающего “разъяснение”, “изложение”, “осведомленность”. Информацию мы передаем друг другу в устной и письменной форме, а также в форме жестов и знаков. Любую нужную информацию мы осмысливаем, передаем другим, на ее основе делаем определенные умозаключения.

Информация – все, что так или иначе зафиксировано в знаковой форме в виде документов.

Все многообразие окружающей нас информации можно сгруппировать по различным признакам:

– по области возникновения. Информация, отражающая процессы, явления неодушевленной природы называется элементарной или механической, процессы животного и растительного мира – биологической, человеческого общества – социальной;

– по способу передачи и восприятия. Информацию, передаваемую видимыми образами и символами, называют визуальной, звуками -аудиальной, ощущениями – тактильной, запахами и вкусами -органолептической; информацию, выдаваемую и воспринимаемую средствами вычислительной техники, – машинной.

– по общественному назначению информацию можно разбить на три вида: личная, массовая и специальная.

Информация должна обладать следующими свойствами:

Информация достоверна, если она отражает истинное положение дел

Информация полна, если ее достаточно для понимания и принятия решений. Как неполная, так и избыточная информация сдерживает принятие решений или может повлечь ошибки.

Точность информации определяется степенью ее близости к реальному состоянию объекта, процесса, явления.

Ценность информации зависит от того, насколько она важна для решения задачи.

Актуальность информации зависит от того, своевременно ли получена информация. Нежелательны как преждевременная подача информации, так и ее задержка.

Информация должна преподноситься в доступной форме.

Кодирование информации — процесс преобразования сигнала из формы, удобной для непосредственного использования информации, в форму, удобную для передачи, хранения или автоматической переработки

Методы измерения количества информации.

Мощность сигнала, также как и размер и вес носителя, не могут служить оценкой количества информации, переносимой сигналом.

В вычислительной технике применяются две стандартные единицы измерения: бит (англ. binary digit –двоичная цифра) и байт (byte).

Конечно, будет правильно, если Вы скажете: “В слове “Рим” содержится 24 бита информации, а в сообщении “Миру мир!” – 72 бита”. Однако, прежде, чем измерить информацию в битах, Вы определяете количество символов в этом сообщении. Нам привычней работать с символами, машине – с кодами. Каждый символ в настоящее время в вычислительной технике кодируется 8-битным или 16-битным кодом. Поэтому, для удобства была введена более “крупная” единица информации в технике (преимущественно в вычислительной) – байт. Теперь Вам легче подсчитать количество информации в техническом сообщении – оно совпадает с количеством символов в нем.

Поскольку компьютер предназначен для обработки больших объемов информации, то используют производные единицы – килобайт (Кб), мегабайт (Мб), гигабайт(Гб).

Обычно приставка “кило” означает тысячу, а приставка “мега” – миллион, но в вычислительной технике все “привязывается” к принятой двоичной системе кодирования.

В силу этого один килобайт равен не тысяче байтов, а 2 10 = 1024 байтов.

Аналогично, 1 Мб = 2 10 Кб = 1024 Кб = 2 20 байт = 1 048 576 байт.

1 Гб = 2 10 Мб = 2 20 Кб = 2 30 байт = 1 073 741 824 байт.

1). Формула Хартли.

I = log2 N или 2 I = N,

где N – количество равновероятных событий (число возможных выборов),

I – количество информации.

2). Модифицированная формула Хартли.

и формула имеет вид

I = log2 (1/p) = – log2 p

где p- вероятность наступления каждого из N возможных равновероятных событий.

3). Формула Шеннона.

где pi – вероятность появления в сообщении i-го символа алфавита;

hi = log2 1/pi = – log2 pi – количество собственной информации, переносимой одним символом;

Н – среднее значением количества информации.

Методы измерения информации

Презентация к уроку

Класс: 10

Образовательная технология: технология развития критического мышления.

Цель урока: ознакомление с основными методами измерения информации и формирование умений вычислить количество информации разными методами.

Задачи урока:

Обучающие:

- краткое знакомство с понятием “количество информации” и с известными методами измерения информации,

- формирование понимания понятия “вероятность”, равновероятных и не равновероятных событий,

- формирование умений вычислить количество информации разными методами.

Воспитывающие:

- воспитание познавательной активности учащихся,

- воспитание положительного отношения учащихся к знаниям,

- воспитание коммуникативной культуры учащихся,

- воспитание интереса к применению методов измерения количества информации в жизни и в профессиональной деятельности.

Развивающие:

- развитие исследовательских навыков учащихся,

- развитие критического мышления при решении практических задач в процессе самостоятельной и групповой исследовательской деятельности учащихся.

Тип урока: урок-лекция с элементами практикума.

Продолжительность урока: 90 минут (спаренный урок).

Методы обучения: объяснительно-иллюстративный, исследовательский.

Оборудование и программное обеспечение:

- интерактивная доска,

- персональный компьютер, мультимедийный проектор и экран для демонстрации учебного материала,

- операционная система MS Windows,

- презентация по данной теме.

План урока:

- Организационный момент. (3 мин)

- Создание проблемной ситуации при постановке темы, цели и задач урока.(7 мин)

- Частичное разрешение проблемной ситуации при реализации намеченного плана урока. (18 мин)

- Применение полученных знаний (15 мин)

- Полное разрешение проблемной ситуации. (20 мин)

- Применение полученных знаний (15 мин)

- Обобщение и систематизация изученного материала. (5 мин)

- Формирование домашнего задания постановкой вопросов для самопроверки. (7 мин)

Ход занятия

1. Организационный момент (проверка присутствующих, проверка готовности к работе).

2. Создание проблемной ситуации при постановке темы, цели и задач урока.

Сегодня мы поговорим о методах измерения количества информации. Понятие информации является одним из фундаментальных понятий современности. Процесс познания окружающего мира приводит к накоплению информации в виде знаний. То есть информация – это знания, которые мы получаем из внешнего мира. Получение новой информации приводит к расширению знаний, т.е., к уменьшению неопределённости нашего знания. Таким образом, мы можем сказать что информация – это сведения об объектах окружающего мира, уменьшающие степень неопределённости нашего знания (см. Рисунок 1).

Очень часто нужно определить количество информации в сообщении. Например, вы получили телеграмму: “Встречайте, вагон №5”. Известно, что в составе поезда 16 вагонов. Как узнать, сколько информации вы получили?

3. Частичное разрешение проблемной ситуации при реализации намеченного плана урока.

Проблема измерения количества информации исследуется в теории информации, основанной американским инженером и математиком Клодом Шенноном. Существует два подхода к измерению информации:

- алфавитный подход,

- содержательный (или вероятностный) подход.

Перед тем, как дать подробное описание указанных подходов, дадим основные определения.

- Алфавит – это множество символов, используемых при записи текста.

- Мощность алфавита – это количество символов алфавита.

- Информационный вес одного символа – это количество информации в одном символе.

- Информационный вессимвола двоичного алфавита принят за единицу измерения информации и называется 1 бит.

Рассмотрим следующую задачу:

Задача 1: Допустим, что мощность алфавита равна S.Чему равно количество информации в сообщении длины l? Известно, что символы этого сообщения принадлежат данному алфавиту.

Впервые эту задачу попытался решить американский инженер Ричард Хартли в 1928 году. Он предложил меру для измерения количества информации в сообщении с равновероятными символами, т.е., в случае, когда ни один из символов не имеет преимущества перед другими символами. Работы Р.Хартли составляют сущность алфавитного подхода измерения информации.

Согласно идеям Р.Хартли, каждый символ сообщения имеет S возможностей выбора. Следовательно, сообщение длины l имеет S l возможностей выбора. Тогда количество информации в сообщении длины l равно логарифму S l :

Заметим, что в задаче Р. Хартли

- Каждый символ сообщения содержит log2(S) информации,

- Следовательно, сообщение длины l должно содержать в l раз больше информации, т.е. l * log2(S) информации.

4. Применение полученных знаний.

Решим следующие задачи.

Задача 2: Симметричная монета с двумя сторонами (названными “Орёл” и “Решка”) бросается вверх. Чему равно количество информации в сообщении о том, что стороной вверх выпала “Решка”?

I = 1 * log2(2) = 1 бит

Задача 3: Бросается симметричный шестигранный игральный кубик, на гранях которого написаны числа 1 – 6. Вычислить количество информации в сообщении о том, что стороной вверх выпала сторона с числом 1.

Ответ: I = log2(6) = 2,585 бит

Задача 4: Сообщение, записанное символами алфавита мощности 32, содержит 80 символов. Чему равно количество информации в сообщении?

Ответ: I = 80 * log2(32) = 80* 5 = 400 бит

5. Полное разрешение проблемной ситуации.

В указанных примерах сообщений возможные события были равновероятны. Но существует множество ситуаций, когда возможные события имеют различные вероятности реализации. Например, если в ящике белых шаров больше, чем чёрных, то вероятнее взять белый шар, чем чёрный. Или, когда сообщают прогноз погоды, то сообщение о том, что будет дождь, более вероятно летом, а сообщение о снеге – зимой. Как вычислить количество информации в сообщении с символами, имеющими разные вероятности?

Американский инженер и математик К. Шеннон продолжил работы Р. Хартли и в 1948 году предложил меру для измерения количества информации в сообщении с символами, имеющими различные вероятности реализации. Работы К. Шеннона составляют сущность содержательного (или вероятностного) подхода измерения информации.

Дадим краткую историческую справку. К. Шеннон является основателем теории информации. Он первым предложил использовать термин “бит” для обозначения наименьшей единицы измерения информации. К. Шеннон ввёл следующие понятия (которые мы рассмотрим на уроке):

- понятие собственной информации как количества информации, содержащей в определённом символе сообщения,

- понятие информационной энтропии как меры неопределенности появления символа в сообщении.

Дадим их краткое описание. Сначала дадим классическое определение вероятности.

Вероятность p случайного события равна отношению числа исходов ki, благоприятствующих данному событию, к общему числу равновозможных исходов: pi = ki/S

К. Шеннон ввёл количество информации (в битах) I(pi) i-го символа алфавита следующим образом:

pi где – вероятность появления i-го символа алфавита.

Величину I(pi) называют собственной информацией i-го символа алфавита.

По формуле собственной информации видно, что чем меньше вероятность i-го символа алфавита, тем больше его собственная информация. Следовательно, в задаче 2 (с бросанием симметричной монеты с двумя сторонами) полученная информация I = 1 бит меньше, чем полученная информация I = 2,585 в задаче 3 (с бросанием симметричного шестигранного игрального кубика). Следовательно, чем меньше мы знаем о сообщении, тем больше информации в ней содержится.

В своей основополагающей работе “Математическая теория связи” (1948 год) (см. [1]) К. Шеннон рассмотрел также среднее количество информации в сообщении, которую назвал информационной энтропией.

Информационная энтропия Н определяется следующим образом:

Дадим краткую историческую справку об энтропии. Понятие энтропии впервые было введено немецким физиком Р. Клаузиусом в термодинамике в 1865 году. Австрийский физик Л. Больцман и американский физик У. Гиббс связали энтропию с вероятностью и описали термодинамическую систему с помощью энтропии. К. Шеннон ввёл понятие энтропии в теорию информации.

Заметим, что информационная энтропия – это мера хаотичности информации, определяющей неопределенность появления символа в сообщении. График двоичной энтропии (при S = 2) в зависимости от p = pi (тогда согласно свойствам вероятности p2 = 1 – p1) приведён на рисунке:

Отметим, что двоичная энтропия  играет большую роль в теории информации.

играет большую роль в теории информации.

Заметим, что информационная энтропия принимает своё максимальное значение ( ) при равновероятных символах, т.е.

) при равновероятных символах, т.е.

В случае равновероятных символов формула Шеннона совпадает с формулой Хартли:

6. Применение полученных знаний.

Решим следующие задачи.

Задача 2: В корзине лежат 8 чёрных и 24 белых шаров. Сколько информации несет сообщение о том, что достали шар фиксированного цвета? Сколько информации несет сообщение о том, что достали шар любого цвета?

Задача 5: Бросается несимметричная четырёхгранная пирамида. Известно, что

являются вероятностями выпадения граней пирамиды. Вычислить количество полученной информации о выпадении какой-то грани пирамиды.

7. Обобщение и систематизация изученного материала.

В ходе урока мы рассмотрели два подхода измерения информации.

- При алфавитном подходе измерения информации предполагается, что все символы алфавита встречаются в сообщениях, записанных с помощью этого алфавита, одинаково часто. Однако в действительности символы алфавитов в сообщениях появляются с разной частотой.

- При вероятностном подходе измерения информации количество информации в сообщении о некотором событии зависит от вероятности этого события. Чем меньше вероятность некоторого события, тем больше информации содержит сообщение об этом событии. Среднее количество информации достигает максимального значения при равновероятных событиях.

8. Формирование домашнего задания постановкой вопросов для самопроверки.

Ну что ж, время урока подходит к концу.

Давайте вспомним, что такое:

- Информация?

- Собственная информация?

- Информационная энтропия?

- Вероятность?

Какие подходы измерения информации вы знаете?

Пожалуйста, повторите дома записи в тетради. Запишите домашнее задание:

Методы измерения количества информации

Содержание:

Ищите профессионального репетитора по информатике и программированию?

Здравствуйте! Меня зовут Александр Георгиевич. Я являюсь профессиональным московским репетитором в области информатики, математики, баз данных и программирования.

Выбрали в качестве официального экзамена ЕГЭ по информатике? Хотите набрать от 93 тестовых баллов? Или возникли трудности с пониманием темы “Методы измерения информации“? Звоните прямо сейчас и записывайтесь ко мне на первый пробный урок.

Также предварительно ознакомьтесь с расписанием и стоимостью моих услуг. Количество ученических мест ограниченно.

Также предлагаю на рассмотрение отзывы клиентов, которые прошли подготовку под моим руководством и достигли поставленных целей.

РЕПЕТИТОР

ПО ИНФОРМАТИКЕ

И ПРОГРАММИРОВАНИЮ

ЧИТАТЬ

ОТЗЫВЫ МОИХ

УЧЕНИКОВ

АДРЕС

ЭЛЕКТРОННОЙ ПОЧТЫ

РЕПЕТИТОРА

ЗАКАЗАТЬ

РАБОТУ ПО

ПРОГРАММИРОВАНИЮ

Основные единицы измерения информации должен знать даже информатический дилетант

Бит является наименьшей единицей измерения информации. Один бит представляет собой количество информации, которое содержится в сообщении, позволяющее вдвое уменьшить неопределенность знаний о чём бы то ни было.

Байт является основной единицей измерения информации. В одном байте содержится 8 бит. Байт – достаточно мелкая единица измерения информации. К примеру, при помощи одного байта можно зашифровать только один символ, используя таблицу ASCII.

Производные единицы измерения информации

Название

Обозначение

Взаимосвязь с другими единицами

1 Кбит = 1024 бит = 2 10 бит

1 Мбит = 1024 Кбит = 2 20 бит

1 Гбит = 1024 Мбит = 2 30 бит

1 Кб = 1024 байт = 2 10 байт

1 Мб = 1024 Кб = 2 20 байт

1 Гб = 1024 Мб = 2 30 байт

Стоит отметить, что прием и передача информации может происходить с различной скоростью. Скоростью передачи информации, либо скоростью информационного потока, является объем информации, переданный за единицу времени. Скорость можно выразить в таких единицах, как бит за секунду (бит/с), байт за секунду (байт/с) и т.п.

Формула Хартли при измерении информации

Как уже было сказано ранее, при помощи одного бита можно вдвое уменьшить неопределенность знаний о чём бы то ни было. При помощи формулы Хартли можно установить связь между количеством возможных событий и объемом информации.

N – число возможных событий; I – объем информации.

Вероятностный метод измерения информации

Применение данного метода возможно только тогда, когда вероятность появления в сообщении каждого из символов не является одинаковой. В таком случае объем информации можно определить при использовании формулы Шеннона:

, где

, где

| N – число возможных событий; | I – объем информации; | Pi – вероятность события i |

Алфавитный метод измерения информации

Представленный метод предусматривает рассмотрение информации в качестве последовательности знаков в выбранной знаковой системе, при этом не концентрируя внимания на самом смысле информации.

Алфавит, который является множеством символов определенного языка, можно интерпретировать как разные события. Следовательно, если вероятность появления каждого символа в сообщении считать одинаковой, применяя формулу Хартли можно определить объем информации, который содержится в каждом символе:

N – число возможных событий; I – объем информации

Использование алфавитного метода измерения информации является наиболее практичным в технических средствах обработки информации.

Алфавитный подход – наиболее объективный способ измерения информации. Этим он отличается от содержательного подхода, который отличается своей субъективностью. Наиболее удобно измерять информацию в тех случаях, когда число символов в алфавите соответствует целой степени 2. Если N = 64, то в каждом символе будет содержаться 6 бит.

Стоит отметить, что в теории максимальный размер алфавита не может быть ограниченным. В связи с этим употребляется такое понятие, как достаточный алфавит. При работе с вычислительной техникой объем достаточного алфавита составляет 256 символов. В такой алфавит помещаются все необходимые символы.

Остались вопросы, недопонимание? Звоните мне на мобильный телефон

Если у вас остались вопросы по рассмотренной теме, то записывайтесь ко мне на индивидуальные уроки по информатике и ИКТ. На своих уроках я делаю акцент на практическую часть, то есть коллегиально со своим учеником мы решаем колоссальное количество различных примеров.

В данной статье рассмотрены только самые ключевые методы измерения информации, но существуют способы замера менее распространенные, но не менее важные для школьника, сдающего ЕГЭ по информатике. Например, комбинаторная мера информация. Уделите 10 минут и внимательно ознакомьтесь с данным методом измерения количества информации.

В отличие от большинства репетиторов я провожу собственные занятия в различных территориальных форматах:

Учитель информатики

Сайт учителя информатики. Технологические карты уроков, Подготовка к ОГЭ и ЕГЭ, полезный материал и многое другое.

§ 1.6. Измерение информации

Информатика. 7 класса. Босова Л.Л. Оглавление

- бит

- информационный вес символа

- информационный объём сообщения

- единицы измерения информации

1.6.1. Алфавитный подход к измерению информации

Одно и то же сообщение может нести много информации для одного человека и не нести её совсем для другого человека. При таком подходе количество информации определить однозначно затруднительно.

Алфавитный подход позволяет измерить информационный объём сообщения, представленного на некотором языке (естественном или формальном), независимо от его содержания.

Для количественного выражения любой величины необходима, прежде всего, единица измерения. Измерение осуществляется путём сопоставления измеряемой величины с единицей измерения. Сколько раз единица измерения «укладывается» в измеряемой величине, таков и результат измерения.

При алфавитном подходе считается, что каждый символ некоторого сообщения имеет определённый информационный вес — несёт фиксированное количество информации. Все символы одного алфавита имеют один и тот же вес, зависящий от мощности алфавита. Информационный вес символа двоичного алфавита принят за минимальную единицу измерения информации и называется 1 бит.

Обратите внимание, что название единицы измерения информации «бит» (bit) происходит от английского словосочетания binary digit — «двоичная цифра».

За минимальную единицу измерения информации принят 1 бит. Считается, что таков информационный вес символа двоичного алфавита.

1.6.2. Информационный вес символа произвольного алфавита

Ранее мы выяснили, что алфавит любого естественного или формального языка можно заменить двоичным алфавитом. При этом мощность исходного алфавита N связана с разрядностью двоичного кода i, требуемой для кодирования всех символов исходного алфавита, соотношением: N = 2 i .

Разрядность двоичного кода принято считать информационным весом символа алфавита. Информационный вес символа алфавита выражается в битах.

Информационный вес символа алфавита i и мощность алфавита N связаны между собой соотношением: N = 2 i .

Задача 1. Алфавит племени Пульти содержит 8 символов. Каков информационный вес символа этого алфавита?

Решение. Составим краткую запись условия задачи.

Известно соотношение, связывающее величины i и N : N = 2 i .

С учётом исходных данных: 8 = 2 i . Отсюда: i = 3.

Полная запись решения в тетради может выглядеть так:

1.6.3. Информационный объём сообщения

Информационный объём сообщения (количество информации в сообщении), представленного символами естественного или формального языка, складывается из информационных весов составляющих его символов.

Информационный объём сообщения I равен произведению количества символов в сообщении К на информационный вес символа алфавита i;I = К • i.

Задача 2. Сообщение, записанное буквами 32-символьного алфавита, содержит 140 символов. Какое количество информации оно несёт?

Задача 3. Информационное сообщение объёмом 720 битов состоит из 180 символов. Какова мощность алфавита, с помощью которого записано это сообщение?

1.6.4. Единицы измерения информации

В наше время подготовка текстов в основном осуществляется с помощью компьютеров. Можно говорить о «компьютерном алфавите», включающем следующие символы: строчные и прописные русские и латинские буквы, цифры, знаки препинания, знаки арифметических операций, скобки и др. Такой алфавит содержит 256 символов. Поскольку 256 = 2 8 , информационный вес каждого символа этого алфавита равен 8 битам. Величина, равная восьми битам, называется байтом. 1 байт — информационный вес символа алфавита мощностью 256.

1 байт = 8 битов

Бит и байт — «мелкие» единицы измерения. На практике для измерения информационных объёмов используются более крупные единицы:

1 килобайт = 1 Кб = 1024 байта = 2 10 байтов

1 мегабайт = 1 Мб = 1024 Кб = 2 10 Кб = 2 20 байтов

1 гигабайт = 1 Гб = 1024 Мб = 2 10 Мб = 2 20 Кб = 2 30 байтов

1 терабайт = 1 Тб = 1024 Гб = 2 10 Гб = 2 20 Мб = 2 30 Кб = 2 40 байтов

Задача 4. Информационное сообщение объёмом 4 Кбайта состоит из 4096 символов. Каков информационный вес символа используемого алфавита? Сколько символов содержит алфавит, с помощью которого записано это сообщение?

Ответ: 8 битов, 256 символов.

Задача 5. В велокроссе участвуют 128 спортсменов. Специальное устройство регистрирует прохождение каждым из участников промежуточного финиша, записывая его номер цепочкой из нулей и единиц минимальной длины, одинаковой для каждого спортсмена. Каков будет информационный объём сообщения, записанного устройством после того, как промежуточный финиш пройдут 80 велосипедистов?

Решение. Номера 128 участников кодируются с помощью двоичного алфавита. Требуемая разрядность двоичного кода (длина цепочки) равна 7, так как 128 = 2 7 . Иначе говоря, зафиксированное устройством сообщение о том, что промежуточный финиш прошёл один велосипедист, несёт 7 битов информации. Когда промежуточный финиш пройдут 80 спортсменов, устройство запишет 80 • 7 = 560 битов, или 70 байтов информации.

Ответ: 70 байтов.

Самое главное.

При алфавитном подходе считается, что каждый символ некоторого сообщения имеет опредёленный информационный вес — несёт фиксированное количество информации.

1 бит — минимальная единица измерения информации.

Информационный вес символа алфавита i и мощность алфавита N связаны между собой соотношением: N = 2 i .

Информационный объём сообщения I равен произведению количества символов в сообщении К на информационный вес символа алфавита i: I = K•i.

1 байт = 8 битов.

Байт, килобайт, мегабайт, гигабайт, терабайт — единицы измерения информации. Каждая следующая единица больше предыдущей в 1024 (210) раза.

Вопросы и задания.

1.Ознакомтесь с материалами презентации к параграфу, содержащейся в электронном приложении к учебнику. Используйте эти материалы при подготовке ответов на вопросы и выполнении заданий.